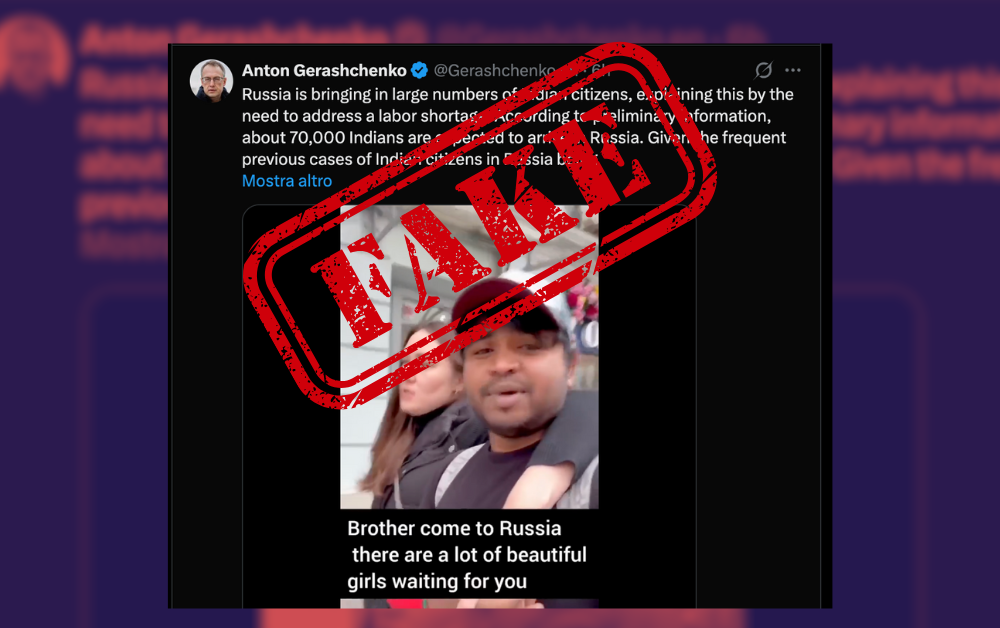

Da alcune ore circola sui social un video in cui un ragazzo parla in Hinglish, un mix di hindi e inglese. Nella versione virale al filmato vengono sovrapposti sottotitoli che gli attribuiscono un messaggio: l’invito a “venire in Russia” perché sarebbe “piena di belle donne, vedove, dato che i mariti sarebbero morti tutti in guerra”.

Il contenuto dei sottotitoli è un falso. La clip viene decontestualizzata e “riscritta” tramite sottotitoli non originali, costruiti per suggerire un’idea precisa e altamente emotiva: la Russia come Paese “svuotato” dagli uomini e popolato da vedove. In realtà, nel parlato non c’è alcun riferimento a “vedove”, “mariti morti” o “guerra”: il senso del video è legato al tema del freddo e delle temperature, un registro tipico di molti contenuti brevi (battute, iperboli, confronto tra i paesi) che vengono facilmente prestati a manipolazioni.

Come si verifica in meno di cinque minuti

Ignorare i sottotitoli inclusi nel video: non sono una fonte. Sono l’elemento manipolatorio principale.

- Ascoltare l’audio originale: anche senza conoscere l’hindi, si riconoscono parole-chiave e il contesto generale; con una trascrizione automatica il controllo diventa immediato.

- Tradurre la trascrizione: strumenti standard di traduzione permettono di capire se compaiono davvero termini e concetti come “war”, “widow”, “husband”, “dead”. Se non compaiono, il “messaggio” è stato inserito dall’esterno.

- Confrontare le versioni: stessa immagine, stesso audio, ma caption e sottotitoli cambiano. È la firma classica della manipolazione e della fake.

Perché costruire una falsificazione del genere

Questo tipo di fake news funziona perché combina tre leve ad altissimo rendimento algoritmico: sessualizzazione, morte e guerra. Non serve dimostrare nulla: basta insinuare. Il sottotitolo “pieno di vedove” non mira a informare, ma a generare reazioni rapide (indignazione, scherno, condivisione), cioè esattamente ciò che le piattaforme premiano.

Sul piano comunicativo, il vantaggio è evidente: invece di discutere di dati verificabili (perdite, mobilitazione, demografia), si sposta la conversazione su un meme morale e degradante. E, soprattutto, si ottiene un contenuto “pronto” per un pubblico vario, perché basta tradurre i sottotitoli in inglese, italiano e altre lingue per farlo viaggiare in circuiti diversi.

Il punto non è solo che i sottotitoli siano falsi. Il punto è che questa falsificazione è stata spinta consapevolmente come “traduzione”, cioè come se fosse un contenuto verificato, verso due pubblici precisi: quello anglofono e quello italiano. In particolare, la clip è rimbalzata dentro circuiti informativi ucraini e pro ucraini dove contano soprattutto i grandi amplificatori: profili che, invece di pubblicare la fonte originale e una trascrizione controllabile, hanno rilanciato il video già “riscritto” dai sottotitoli. Tra i nomi che ricorrono nelle condivisioni e negli screenshot circolati ci sono Anton Gerashchenko e Vladislav Maistrouk, ciascuno in segmenti linguistici diversi. Non ci troviamo di fronte a chi fa informazione, ma a chi usa un “metodo”. Perché qui non si sta “sbagliando traduzione”, si sta costruendo un messaggio: guerra, morte, sesso, vedove. Il pacchetto perfetto per diventare virale.

La regola pratica

Quando un video circola con sottotitoli non attribuiti all’autore e senza link all’originale, la probabilità di manipolazione è alta. In questi casi, la verifica non richiede competenze specialistiche: basta partire dall’audio, non dal testo aggiunto sopra il video.